Remerciements

L’auteure principale de cet article souhaite exprimer sa reconnaissance envers la Fondation CRHA pour la bourse de recherche offerte, ce qui a permis la réalisation de ce travail.

Table des matières

- Droits d’auteur

- Résumé

- Introduction

- 1. Qu’est-ce qu’un agent conversationnel?

- 2. ChatGPT : un agent conversationnel de pointe

- 3. Utilisation des agents conversationnels dans la GRH

- 4. Défis et enjeux éthiques de l’utilisation des agents conversationnels dans la GRH

- Conclusion

- Références

- ANNEXE 1

- ANNEXE 2

Droits d’auteur

La reproduction, la publication et communication de ce document dans son intégralité sous quelque forme ou par quelque moyen (électronique, mécanique ou autre, y compris la photocopie, l’enregistrement ou l’introduction dans tout système informatique de recherche documentaire) est interdite sans le consentement écrit de l’Ordre des conseillers en ressources humaines agréés.

Avis d’utilisation

Dans le cadre de sa mission de protection du public, l’Ordre des conseillers en ressources humaines agréés vous propose ce document. Les propos qui y sont exprimés n’engagent que leur auteur et l’Ordre des conseillers en ressources humaines et en relations industrielles agréés décline toute responsabilité à leurs égards.

Résumé

Le monde évolue à une vitesse vertigineuse et la technologie progresse de concert. Une révolution est en cours, et les agents conversationnels, dont ChatGPT est le chef de file, jouent un rôle prépondérant dans ce changement. Grâce à ses aptitudes remarquables en traitement du langage naturel, ChatGPT ouvre de nouvelles perspectives de communication entre humains et machines, générant un intérêt sans pareil dans de nombreux domaines, y compris la gestion des ressources humaines (GRH).

Dans cet article, nous explorerons le concept des agents conversationnels, en mettant l’accent sur le ChatGPT, l’un des modèles les plus avancés de cette technologie, développé par la compagnie OpenAI. Nous analyserons également comment ces agents conversationnels révolutionnent la GRH et de quelle façon ils peuvent être utilisés de manière bénéfique pour les entreprises et les employés. Enfin, nous aborderons les limites, les enjeux éthiques et la responsabilité qui accompagnent le recours aux agents conversationnels dans la GRH.

Introduction

Les avancées technologiques ont permis l’émergence d’outils révolutionnaires tels que les agents conversationnels, aussi appelés agents virtuels, chatbots ou systèmes de dialogue automatisés. Ce sont des programmes informatiques qui interagissent avec les utilisateurs de manière naturelle et efficace, en utilisant des technologies comme le traitement du langage naturel (natural language processing - NLP) et l’apprentissage automatique (machine learning - ML). Ils ont de nombreuses applications dans divers domaines, notamment les actualités, le divertissement ou le contrôle des maisons intelligentes (Bavaresco et al., 2020). Ils sont également utilisés en contexte professionnel, comme celui de la GRH (Maurer, 2019; Sheth, 2018).

Les agents conversationnels peuvent apporter une valeur ajoutée à la GRH, qui réunit l’ensemble des pratiques relatives à la gestion des employés pour atteindre les objectifs de l’organisation (Robert-Huot & Cloutier, 2020). En effet, les agents conversationnels peuvent faciliter la communication entre les gestionnaires, les recruteurs, les employés et les services RH. Plusieurs organisations ont adopté des agents conversationnels en GRH et en tirent des avantages (Laumer & Morana, 2022). Par exemple, Siemens a lancé Carl, un agent virtuel qui permet de rehausser la qualité du service RH en diminuant le nombre de demandes de soutien des employés et en libérant du temps aux professionnels RH pour des tâches plus stratégiques (IBM, 2019). La recherche se penche également sur les meilleurs usages possibles des agents conversationnels en GRH (Listikova et al., 2020). Les agents conversationnels permettent d’optimiser les processus de recrutement, de formation, de développement et de gestion des performances des employés et peuvent assister les employés au quotidien (Laumer & Morana, 2022). Leurs capacités à comprendre le langage naturel et à fournir des réponses rapides et précises les rendent particulièrement adaptés à ces tâches.

Grâce à l’intégration judicieuse des agents conversationnels dans la GRH, les entreprises peuvent espérer optimiser leurs processus, renforcer l’engagement des employés et améliorer la satisfaction au travail. Cependant, il est crucial de comprendre les tenants et aboutissants de cette technologie afin de l’exploiter de manière responsable et éthique.

-

Qu’est-ce qu’un agent conversationnel?

Les agents conversationnels sont des programmes informatiques conçus pour interagir avec les utilisateurs. Leur principal objectif est de simuler une conversation humaine, en comprenant des demandes et en générant des réponses cohérentes et pertinentes au moyen d’une interface textuelle ou vocale (Laumer & Morana, 2022). Ils utilisent des bases de données, des connaissances diversifiées et une logique de décisions pour répondre aux questions des utilisateurs, imitant ainsi la conversation humaine par le biais de canaux de communication tels que la parole, le texte, et parfois les expressions faciales et les gestes (Laranjo et al., 2018).

Les agents conversationnels se distinguent donc selon leur mode de communication (verbale ou écrite) et leur contexte d’utilisation (général ou particulier à un domaine) (Laumer & Morana, 2022). Les agents conversationnels basés sur la parole sont appelés assistants personnels intelligents; Alexa, Siri et Cortana en sont les représentations les plus connues. En parallèle, les agents basés sur le texte sont appelés chatbots et sont utilisés dans divers domaines comme le service à la clientèle ou la santé. Certains agents conversationnels sont également personnifiés, offrant une représentation visuelle d’allure humaine en plus de l’interaction texte ou parole. C’est le cas de Replika, qui se présente comme un ami virtuel et qui adapte sa personnalité et son apparence aux préférences de l’utilisateur (CBC, 2021).

Il est important de noter que les agents conversationnels peuvent adopter différentes architectures de programmation et approches de conception, en fonction des objectifs et des contraintes spécifiques (Korngiebel & Mooney, 2021). Certains agents conversationnels sont basés sur des règles prédéfinies, où chaque type de requête a une réponse correspondante programmée à l’avance (p. ex., le chatbot de Sephora qui aide les clients à trouver le produit de beauté adapté à leurs besoins). D’autres agents conversationnels plus avancés (p. ex., ChatGPT) utilisent des modèles de langage préentraînés (p. ex., GPT-3 et ses versions ultérieures) (Floridi & Chiriatti, 2020), qui sont capables d’apprendre de manière automatique et non supervisée, à partir de grandes quantités de données textuelles et de générer des réponses plus flexibles et adaptatives, dans un langage naturel (Korngiebel & Mooney, 2021).

-

ChatGPT : un agent conversationnel de pointe

Parmi les avancées majeures dans le domaine des agents conversationnels, ChatGPT occupe une place prépondérante depuis son lancement en novembre 2022 (Smith, 2023).

ChatGPT est un agent conversationnel qui génère du texte naturel pour interagir avec les utilisateurs. Il utilise un modèle de langage préentraîné sur des corpus textuels massifs, le GPT (Generative Pre-trained Transformer), qui est le plus volumineux et le plus sophistiqué à ce jour (OpenAI, 2022). Par exemple, le modèle de langage GPT-3, qui compte plus de 175 milliards de paramètres, a été amélioré avec son itération toujours active GPT-3.5, qui en compte plus de 200 milliards. Cette version a été suivie par GPT-4, un modèle de langage multimodal qui dispose de plus de 300 milliards de paramètres et qui peut traiter des entrées d’images et de texte, offrant une fiabilité, une créativité et une collaboration améliorées, ainsi qu’une plus grande capacité à traiter des instructions plus nuancées (OpenAI, 2023).

Selon une étude récente (Hassani & Silva, 2023), ChatGPT est capable d’aider dans de nombreuses tâches de science des données, telles que la traduction, l’analyse et la classification, menant à une amélioration du flux de travail et l’obtention de meilleurs résultats. Il peut être utilisé par divers types d’utilisateurs, tels que les utilisateurs de réseaux sociaux, les auteurs de fiction, les journalistes, les chercheurs et les spécialistes du marketing (Singh, 2023).

En plus des capacités particulières mentionnées précédemment, ChatGPT en possède également d’autres, qui en font un outil polyvalent et puissant. . Par exemple :

- Génération de texte similaire à celui écrit par des humains : il est capable de produire du texte qui ressemble à celui écrit par des humains. Cela est particulièrement utile pour la création de contenu tel que des articles, des descriptions de produits, des scénarios, etc. Il peut aider à générer des idées, des titres, des descriptions et des paragraphes complets.

- Assistance à la rédaction : il peut fournir des suggestions et compléter automatiquement le texte lors de la rédaction de courriels, d’essais, de rapports ou de code de programmation. Il peut aider à améliorer la clarté et la cohérence du texte.

- Réponse à des questions sur divers sujets : il est en mesure de répondre à des questions portant sur des sujets précis qu’il s’agisse d’événements historiques, de concepts scientifiques, d’informations générales, etc. Il peut fournir des définitions, des explications et des exemples pour aider à la compréhension.

- Traduction de texte entre plusieurs langues : il peut être utilisé comme un outil de traduction pour faciliter la communication dans différentes langues. Il peut traduire des phrases, des paragraphes ou des documents entiers.

- Assistance au codage : il peut aider les développeurs en proposant des suggestions de codes informatiques, en donnant des explications sur des concepts de programmation, en résolvant des problèmes courants et en fournissant des exemples de code. Cela peut accélérer le processus de développement de logiciels et aider à surmonter les obstacles techniques.

ChatGPT est donc un modèle avancé capable de générer du texte de manière pertinente en réponse à une sollicitation ou à un contexte donné, grâce à son architecture puissante et à son apprentissage sur de vastes ensembles de données (Bar, 2023). Il est en constante évolution afin d’améliorer ses compétences linguistiques et offrir des expériences utilisateurs de haute qualité. Cependant, ChatGPT peut présenter plusieurs limites qu’il faut comprendre afin d’en assurer un usage adéquat (Marr, 2023).

Bien qu’il soit capable de générer des réponses qui s’inscrivent naturellement dans la conversation, il ne possède pas une véritable compréhension du contenu et du contexte des conversations. Au lieu de cela, il génère des réponses basées sur des associations statistiques apprises à partir de vastes ensembles de données d’entraînement. Cela peut parfois entraîner des erreurs d’interprétation ou l’ignorance d’éléments importants du contexte, ce qui peut se traduire par des réponses inexactes ou inappropriées (Marr, 2023).

De plus, les données sur lesquelles ChatGPT est entraîné proviennent de textes accessibles au public et peuvent contenir des informations biaisées, périmées ou inexactes, car ces données s’arrêtent en 2021 (OpenAI, 2022). Il est important de reconnaître que ChatGPT peut manquer de discernement dans certaines situations. En raison de la diversité des sources de données utilisées pour l’entraînement, il peut fournir des informations trompeuses ou reproduire certains biais présents dans ces données (Billon, 2023; Cousins, 2023). Par exemple, lorsqu’on lui demande d’insérer des références dans un texte pour soutenir les affirmations, la majorité est fictive, donc inexistante, même si leur forme respecte les normes en vigueur. ChatGPT s’appuie sur un modèle de langage de grande envergure et n’a pas la compétence de sélectionner des sources pertinentes pour un sujet donné (Hillier, 2023). Il peut réussir avec certains sujets ou sources, mais il peut également créer des sources plausibles, mais qui n’existent pas (Welborn, 2023).

Dans sa revue de littérature, Ray (2023) présente d’autres limites de ChatGPT, comme une incapacité à s’assurer de la véracité des faits. Le modèle a aussi du mal à raisonner de façon éthique. En outre, ChatGPT peut ne pas savoir comment répondre à des demandes insuffisamment expliquées et comment donner un retour personnalisé aux besoins de chaque personne. Les limites incluent aussi des problèmes avec les langues différentes, le langage figuré (p. ex., les expressions ou les métaphores), la créativité et la qualité constante (pour la liste exhaustive et la description de limites répertoriées par Ray, 2023, voir l’Annexe 1).

Pour aller un peu plus loin au sujet des informations trompeuses, il est également nécessaire de s’intéresser aux biais pouvant être présents dans les réponses de ChatGPT (les lecteurs qui le souhaitent peuvent consulter la liste des biais répertoriés par Ray, 2023 à l’Annexe 2).

Un article publié par Forbes (Cousins, 2023), présente quelques catégories de biais que ChatGPT peut manifester, dont certains proviennent d’entrées reçues par le programme, tandis que d’autres viennent avec sa nature générative ou sont générés par les utilisateurs. Voici quatre de ces catégories :

- Le biais de moralité programmatique. Il s’agit d’un biais introduit par l’entreprise lors de la programmation de ChatGPT. OpenAI a pris des décisions pour influencer les réponses du modèle afin qu’il reflète une sorte de norme ou de perspective morale particulière. Cela peut être fait dans le but de rendre le logiciel plus politiquement correct ou d’éviter de donner des réponses qui pourraient être considérées comme controversées ou offensantes. Cependant, cela signifie que les réponses de ChatGPT peuvent être influencées par les valeurs ou les opinions émanant de l’entreprise, ce qui peut ne pas correspondre à celles de tous les utilisateurs. Certains peuvent apprécier cette orientation vers la « correction sociale », tandis que d’autres peuvent préférer une approche plus neutre ou diversifiée.

- Le préjugé de l’ignorance. Bien que ChatGPT puisse fournir des informations provenant de sources existantes, il ne possède pas une compréhension approfondie ou une capacité à raisonner logiquement comme un être humain. Il peut utiliser ses connaissances encyclopédiques pour récupérer des informations déjà disponibles, mais il ne peut pas générer de nouvelles connaissances ou faire preuve de raisonnement abstrait. De plus, il peut ne pas être en mesure de répondre de manière approfondie ou de résoudre des problèmes complexes qui nécessitent une réflexion critique et créative. Il est donc préférable de considérer ChatGPT comme une ressource complémentaire pouvant contribuer à trouver des informations existantes, mais il est toujours important de faire appel à son propre jugement et de faire preuve de discernement lors de l’évaluation des réponses fournies par le modèle.

- Le biais de fenêtre d’Overton. Ce biais souligne que ChatGPT est susceptible de se limiter à des affirmations qui sont considérées comme socialement acceptables et non controversées, conformément à ce que l’on appelle la fenêtre d’Overton. Ce biais peut conduire à ignorer ou à rejeter les idées qui se situent en dehors de cette fenêtre, même si elles sont fondées ou pertinentes (Dupont, 2022). Cela signifie qu’il peut éviter des sujets délicats ou donner des réponses reposant sur des informations contradictoires ou peu fiables, mais présentes dans ses données d’entraînement. Il est donc important d’exercer un esprit critique lors de l’utilisation des réponses de ChatGPT et de se rappeler qu’il peut ne pas toujours fournir une perspective équilibrée ou complète, en particulier sur des sujets controversés.

- Les préjugés de déférence. Ce biais souligne que les êtres humains peuvent accorder une confiance excessive et aveugle à l’IA, en se reposant sur elle comme une autorité suprême. Cela peut se manifester par une dépendance excessive à la technologie, une soumission à l’autorité perçue de l’IA, voire une défense fervente de son rôle vertueux. Ce biais peut être alimenté par des facteurs tels que la charge de travail élevée, les défis rencontrés dans le monde et les circonstances stressantes, comme la pandémie de COVID-19. Il est important de maintenir un équilibre et de conserver son autonomie intellectuelle lors de l’utilisation de l’IA, en évitant de céder trop facilement à son influence et en gardant un esprit critique et indépendant.

Il faut donc être vigilant et s’assurer que ChatGPT et sa famille d’agents conversationnels sont régulièrement audités et améliorés pour minimiser les risques de biais et de discrimination.

-

Utilisation des agents conversationnels dans la GRH

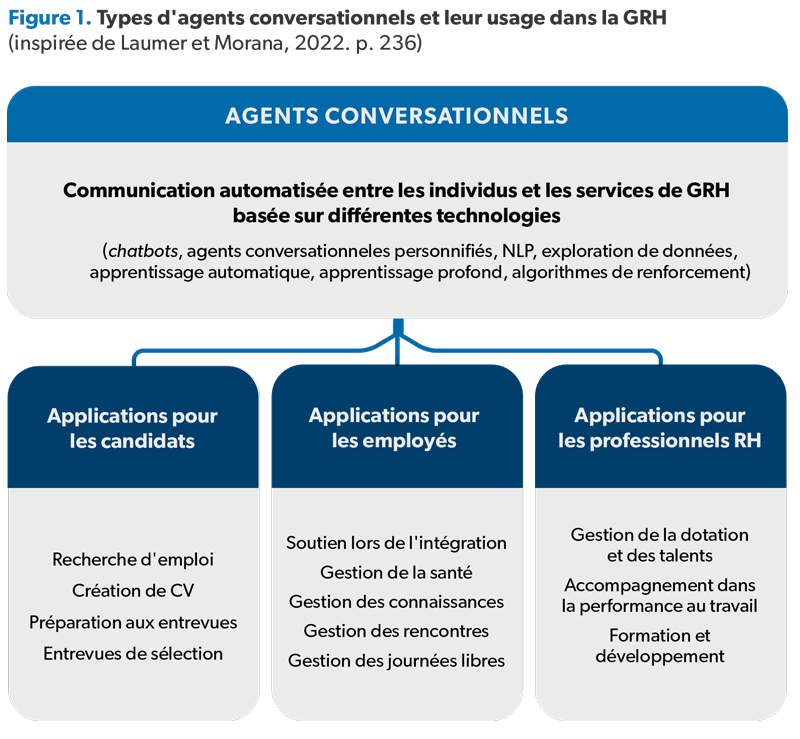

D’après une récente recension de la documentation scientifique existante sur l’utilisation des interfaces conversationnelles et des agents conversationnels dans le domaine de la GRH (Laumer & Morana, 2022), il a été constaté que ces agents peuvent apporter un soutien aux services de GRH en utilisant le traitement du langage naturel (NLP) et d’autres technologies, tout en automatisant la communication entre les prestataires de services de GRH et les individus qui en font la demande. Les auteurs de cette recension ont classifié les utilisations des agents conversationnels en GRH en trois catégories : ceux destinés aux candidats, ceux destinés aux employés et ceux destinés aux professionnels de la GRH (voir Figure 1). Ces agents conversationnels permettent aux individus de demander différents services de GRH ou de poser des questions pertinentes à la GRH.

Au-delà du schéma descriptif ci-dessus, les agents conversationnels semblent offrir de nombreux autres avantages et applications dans le domaine de la GRH (Koivunen et al., 2022). Ils peuvent améliorer les processus de recrutement, de formation, de développement et de gestion des performances des employés (Goirand, 2023). Ils peuvent également automatiser les tâches quotidiennes, libérant le personnel des ressources humaines qui peut alors se concentrer sur des tâches plus stratégiques (Camilleri & Troise, 2023; Majumder & Mondal, 2021). Dans ce texte, nous allons présenter quelques exemples d’utilisation des agents conversationnels dans la GRH.

-

Recrutement et sélection

Les agents conversationnels peuvent jouer un rôle clé dans le processus de recrutement et de sélection des candidats (Goirand, 2023). Ils peuvent interagir avec les candidats, poser des questions sur leur expérience, leurs compétences et leurs préférences, et fournir des informations sur l’entreprise et les postes vacants. Ils peuvent trier et préqualifier les candidatures reçues, réduisant la charge de travail des recruteurs tout en accélérant le processus de présélection (Allal-Chérif et al., 2021).

Les agents conversationnels peuvent également mener des entrevues virtuelles avec les candidats, poser des questions préétablies, évaluer les réponses et fournir une première évaluation. Cela permet aux recruteurs d’économiser du temps et des ressources en cernant rapidement les candidats les plus prometteurs pour passer aux étapes de sélection suivantes (Allal-Chérif et al., 2021).

De plus, les agents conversationnels peuvent aider à la collecte et à l’analyse des données des candidats, facilitant ainsi la prise de décision lors du processus de sélection (Allal-Chérif et al., 2021).

-

Intégration et formation initiale

Lorsqu’un nouvel employé se joint à une entreprise, il est confronté à de nombreux défis. Il doit apprendre à connaître ses collègues, comprendre les politiques et les procédures de l’entreprise et s’adapter à son nouvel environnement de travail. Cela peut être un processus long et difficile, mais les agents conversationnels peuvent faciliter cette transition (Følstad et al., 2021; Majumder & Mondal, 2021).

Les agents conversationnels peuvent répondre aux questions des nouveaux employés et les aider à se familiariser avec leur nouvel environnement de travail (Clark, 2020; Majumder & Mondal, 2021; TalentLyft, 2020). Ils peuvent également être utilisés pour dispenser des formations initiales aux nouveaux employés (Clark, 2020; Majumder & Mondal, 2021; TalentLyft, 2020) et fournir des informations sur les politiques et les procédures de l’entreprise, ainsi que sur les ressources internes pertinentes.

-

Soutien aux employés

Les agents conversationnels peuvent jouer un rôle important dans le soutien aux employés en répondant à leurs questions fréquentes sur les avantages sociaux, les congés, les politiques internes, et autres (Camilleri & Troise, 2023; Majumder & Mondal, 2021). En fournissant une assistance et un soutien continu, ils peuvent améliorer l’expérience des employés ce qui peut conduire à un engagement et une satisfaction accrus au travail (Taule et al., 2022). En facilitant le quotidien des collaborateurs, ils peuvent améliorer leur expérience (Adamopoulou & Moussiades, 2020).

De plus, les agents conversationnels sont disponibles 24 heures sur 24, 7 jours sur 7, 365 jours par année. Cela signifie qu’ils peuvent offrir un soutien continu aux employés, même en dehors des heures de travail normales. Ceci peut être particulièrement utile pour les personnes travaillant le soir, la nuit ou les fins de semaine. Les employés peuvent poser des questions à tout moment et obtenir des réponses rapidement, ce qui peut améliorer leur satisfaction et leur productivité (Camilleri & Troise, 2023; Majumder & Mondal, 2021; Wilson & Marasoiu, 2022).

Ainsi, ils peuvent contribuer à réduire les coûts en optimisant le service, en limitant le recours à des employés humains et en améliorant la satisfaction des employés (Mydyti & Kadriu, 2021). Par exemple, un agent conversationnel peut informer le client ou l’utilisateur sur un produit, un service ou une procédure, sans qu’il soit nécessaire de solliciter un agent humain. Cela permet de faire des économies sur les coûts liés au recrutement, à la formation et au salaire des employés humains, ainsi que d’éviter des tâches routinières ou pénibles.

-

Performance au travail

Les agents conversationnels peuvent avoir de nombreuses applications dans la performance au travail. Ils peuvent aider à alléger la charge de travail des services aux clients en répondant aux questions simples et en écourtant les temps d’attente (Curiale et al., 2022). Ils peuvent automatiser les tâches à faible valeur ajoutée, permettant ainsi aux professionnels des RH de se concentrer sur des tâches plus stratégiques (Deloitte, 2019). De plus, ils ont le potentiel de fournir des données claires sur les exigences et les préférences des employés, qui peuvent ensuite être utilisées pour guider la prise de décision en matière de ressources humaines (Taule et al., 2022).

ChatGPT et sa famille élargie d’agents conversationnels peuvent apporter de nombreux avantages aux entreprises sur le plan de la GRH, comme démontré ci-dessus. Cependant, il faut reconnaître que les agents conversationnels ne peuvent pas se substituer totalement à l’interaction humaine et qu’ils doivent être utilisés de manière avertie en complément des processus de GRH existants.

-

-

Défis et enjeux éthiques de l’utilisation des agents conversationnels dans la GRH

L’utilisation des agents conversationnels en GRH soulève également des questions importantes en termes d’éthique et de responsabilité.

L’une des préoccupations principales concerne la protection de la vie privée des employés. Les agents conversationnels traitent souvent des informations délicates sur les employés, comme leurs données personnelles, leurs évaluations de performance ou leurs problèmes personnels (Hill, 2023). Il faut donc mettre en place des mesures de sécurité appropriées pour protéger la confidentialité de ces données et garantir la conformité aux réglementations en matière de protection des données, comme la Loi sur l’accès aux documents des organismes publics et sur la protection des renseignements personnels (RLRQ, chapitre A-2.1, 2023) et la Loi sur la protection des renseignements personnels dans le secteur privé (RLRQ, chapitre P-39.1, 2023) au Québec. Les organisations doivent s’assurer que les agents conversationnels sont conçus avec des protocoles de sécurité robustes et que seules les personnes autorisées ont accès aux informations confidentielles. De plus, les entreprises doivent être transparentes sur les données collectées par les agents conversationnels et informer les employés de leur utilisation. Les employés doivent aussi pouvoir contrôler les données collectées à leur sujet et avoir le droit de supprimer ces données s’ils le souhaitent. Le consentement libre et éclairé est donc de mise.

Les entreprises ont la responsabilité de garantir que les données collectées sont utilisées de manière éthique et responsable, et que les décisions prises par les agents conversationnels sont équitables et objectives. Dans cette optique, il est essentiel pour les entreprises d’évaluer régulièrement l’incidence du recours à des agents conversationnels sur les employés, et sur l’entreprise dans son ensemble, afin de s’assurer qu’ils sont utilisés de manière efficace et éthique. Ainsi, il est primordial que les entreprises établissent des politiques claires concernant l’utilisation des agents conversationnels, et qu’elles forment leurs employés à leur utilisation. En outre, la surveillance continue de des répercussions des agents conversationnels sur les employés et sur l’entreprise est indispensable pour veiller à leur utilisation responsable et éthique.

Les agents conversationnels avancés sont capables de générer du contenu hautement persuasif ou émotionnellement saisissant (Ray, 2023). Cette capacité soulève des préoccupations éthiques quant au potentiel de manipulation, car le contenu généré par l’IA pourrait être utilisé pour exploiter les émotions des personnes, influencer leurs croyances ou comportements, ou promouvoir la désinformation. Les organisations devraient s’assurer que ChatGPT ou tout autre agent conversationnel, lorsqu’adopté, est utilisé de manière responsable pour prévenir de tels abus.

La nature des modèles linguistiques avancés de l’IA peut rendre difficile la détermination de la responsabilité en cas d’erreurs ou de préjudices. L’autonomie croissante des systèmes d’IA rend plus complexe la question de l’imputation de la responsabilité aux développeurs, aux utilisateurs ou à l’IA elle-même. Il est donc nécessaire de définir des lignes directrices claires et des cadres juridiques afin de répondre à ce défi (Ray, 2023).

Enfin, notons que cet article présente seulement quelques-uns des nombreux défis éthiques auxquels ChatGPT et sa famille élargie d’agents conversationnels, en tant que modèles de langage IA avancés, sont confrontés (Ray, 2023). Ces défis variés nécessitent une attention particulière afin d’assurer un développement et une utilisation responsables de cette technologie. Pour garantir que ChatGPT et ses homologues répondent aux normes éthiques les plus élevées, il est primordial de les prendre en compte et de remédier à ces défis.

Conclusion

Les agents conversationnels en général, mais surtout ChatGPT, en tant que modèle avancé, offrent un grand potentiel pour réformer la GRH en relevant l’efficacité des processus et en offrant une meilleure expérience aux employés. Les avantages du recours aux agents conversationnels sont nombreux, entre autres la réduction des coûts, l’amélioration de l’expérience utilisateur et la possibilité d’automatiser les tâches répétitives.

Cependant, l’utilisation des agents conversationnels en GRH pose également des défis importants, notamment sur le plan du respect de la vie privée, de biais algorithmiques et de responsabilité des entreprises. Les entreprises doivent être conscientes de ces défis et mettre en place des lignes directrices, des politiques et des pratiques qui garantissent l’utilisation responsable et éthique des agents conversationnels afin de ne pas nuire aux humains.

En fin de compte, il est important de souligner que l’utilisation des agents conversationnels doit être guidée par des considérations éthiques et sociales. Les entreprises doivent être responsables des répercussions de l’utilisation des agents conversationnels sur leurs employés et sur l’ensemble de la société. En adoptant une approche responsable et éthique, les entreprises peuvent mieux s’assurer que les avantages des agents conversationnels seront pleinement obtenus et que leurs employés bénéficieront d’une expérience améliorée dans les processus de GRH.

Références

- Adamopoulou, E., & Moussiades, L. (2020). Chatbots: History, technology, and applications. Machine Learning with Applications, 2, 100006. https://doi.org/10.1016/j.mlwa.2020.100006

- Allal-Chérif, O., Yela Aránega, A., & Castaño Sánchez, R. (2021). Intelligent recruitment: How to identify, select, and retain talents from around the world using artificial intelligence. Technological Forecasting and Social Change, 169, 120822. https://doi.org/10.1016/j.techfore.2021.120822

- Bar, B. (2023). ChatGPT : le guide pour tout comprendre. https://www.journaldunet.com/solutions/dsi/1518183-chatgpt-le-guide-pour-tout-comprendre/

- Bavaresco, R., Silveira, D., Reis, E., Barbosa, J., Righi, R., Costa, C., Antunes, R., Gomes, M., Gatti, C., Vanzin, M., Junior, S. C., Silva, E., & Moreira, C. (2020). Conversational agents in business: A systematic literature review and future research directions. Computer Science Review, 36, 100239. https://doi.org/10.1016/j.cosrev.2020.100239

- Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021). On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?. Proceedings of the 2021 ACM Conference on Fairness, Accountability, and Transparency, 610‑623. https://doi.org/10.1145/3442188.3445922

- Billon, J. (6 mars 2023). Limites de ChatGPT : 7 inconvénients à connaître. BDM. https://www.blogdumoderateur.com/limites-chatgpt-inconvenients/

- Camilleri, M. A., & Troise, C. (2023). Live support by chatbots with artificial intelligence: A future research agenda. Service Business, 17(1), 61‑80. https://doi.org/10.1007/s11628-022-00513-9

- CBC. (2021). After her best friend died, this programmer created an AI chatbot from his texts to talk to him again | CBC Documentaries. CBC Tea Nature of Things. https://www.cbc.ca/documentaries/the-nature-of-things/after-her-best-friend-died-this-programmer-created-an-ai-chatbot-from-his-texts-to-talk-to-him-again-1.6252286

- Clark, S. (2020). 5 Ways Chatbots Improve Employee Experience. Reworked. Co; Simpler Media Group, Inc. https://www.reworked.co/employee-experience/5-ways-chatbots-improve-employee-experience/

- Cousins, B. (2023). Council Post: Uncovering The Different Types Of ChatGPT Bias. Forbes. https://www.forbes.com/sites/forbestechcouncil/2023/03/31/uncovering-the-different-types-of-chatgpt-bias/

- Curiale, T., Acquatella, F., Gros, L., Cosquer, M., & Tisseron, S. (2022). L’anthropomorphisme, enjeu de performance pour les chatbots. Revue internationale de psychosociologie et de gestion des comportements organisationnels, XXVIII(72), 101‑123. https://doi.org/10.3917/rips1.072.0101

- Deloitte. (2019). Transform HR with intelligent chatbots. https://www2.deloitte.com/content/dam/Deloitte/global/Documents/Technology/gx-tech-transform-hr-with-intelligent-chatbots.pdf

- Dupont, M. (16 février 2022). La fenêtre d’Overton ou le champ de l’acceptable en politique. Le Monde.fr. https://www.lemonde.fr/idees/article/2022/02/16/la-fenetre-d-overton-ou-le-champ-de-l-acceptable-en-politique_6113836_3232.html

- Floridi, L., & Chiriatti, M. (2020). GPT-3: Its Nature, Scope, Limits, and Consequences. Minds and Machines, 30(4), 681‑694. https://doi.org/10.1007/s11023-020-09548-1

- Følstad, A., Araujo, T., Law, E. L.-C., Brandtzaeg, P. B., Papadopoulos, S., Reis, L., Baez, M., Laban, G., McAllister, P., Ischen, C., Wald, R., Catania, F., Meyer von Wolff, R., Hobert, S., & Luger, E. (2021). Future directions for chatbot research: An interdisciplinary research agenda. Computing, 103(12), 2915‑2942. https://doi.org/10.1007/s00607-021-01016-7

- Goirand, T. (10 février 2023). Chat GPT : 12 exemples de son utilisation en recrutement. DigitalRecruiters, A Cegid company. https://www.digitalrecruiters.com/blog/12-exemples-chatgpt-transformation-recrutement

- Hassani, H., & Silva, E. S. (2023). The Role of ChatGPT in Data Science: How AI-Assisted Conversational Interfaces Are Revolutionizing the Field. Big Data and Cognitive Computing, 7(2), Article 2. https://doi.org/10.3390/bdcc7020062

- Hill, M. (22 mars 2023). Sharing sensitive business data with ChatGPT could be risky. CSO Online. https://www.csoonline.com/article/3691115/sharing-sensitive-business-data-with-chatgpt-could-be-risky.html

- Hillier, M. (20 février 2023). Why does ChatGPT generate fake references? TECHE. https://teche.mq.edu.au/2023/02/why-does-chatgpt-generate-fake-references/

- IBM. (2019). Siemens AG : A one-of-a-kind AI-based virtual agent innovates employee support. https://www.ibm.com/case-studies/siemens-ag-watson-ai

- Koivunen, S., Ala-Luopa, S., Olsson, T., & Haapakorpi, A. (2022). The March of Chatbots into Recruitment: Recruiters’ Experiences, Expectations, and Design Opportunities. Computer Supported Cooperative Work (CSCW), 31(3), 487‑516. https://doi.org/10.1007/s10606-022-09429-4

- Korngiebel, D. M., & Mooney, S. D. (2021). Considering the possibilities and pitfalls of Generative Pre-trained Transformer 3 (GPT-3) in healthcare delivery. npj Digital Medicine, 4(1), 93. https://doi.org/10.1038/s41746-021-00464-x

- Laranjo, L., Dunn, A. G., Tong, H. L., Kocaballi, A. B., Chen, J., Bashir, R., Surian, D., Gallego, B., Magrabi, F., Lau, A. Y. S., & Coiera, E. (2018). Conversational agents in healthcare: A systematic review. Journal of the American Medical Informatics Association, 25(9), 1248‑1258. https://doi.org/10.1093/jamia/ocy072

- Laumer, S., & Morana, S. (2022). HR natural language processing—Conceptual overview and state of the art on conversational agents in human resources management. Dans Handbook of Research on Artificial Intelligence in Human Resource Management (p. 226‑242). Edward Elgar Publishing. https://www.elgaronline.com/display/edcoll/9781839107528/9781839107528.00022.xml

- Listikova, A. V., Egorov, E. E., Lebedeva, T. E., Bulganina, S. V., & Prokhorova, M. P. (2020). Research of the Best Practices of Artificial Intelligence in the Formation and Development of Personnel. Dans E. G. Popkova (Éd.), Growth Poles of the Global Economy: Emergence, Changes and Future Perspectives (p. 1345‑1352). Springer International Publishing. https://doi.org/10.1007/978-3-030-15160-7_137

- Long, Y., Hui, B., Ye, F., Li, Y., Han, Z., Yuan, C., Li, Y., & Wang, X. (2023). SPRING : Situated Conversation Agent Pretrained with Multimodal Questions from Incremental Layout Graph (arXiv:2301.01949). arXiv. https://doi.org/10.48550/arXiv.2301.01949

- Majumder, S., & Mondal, A. (2021). Are chatbots really useful for human resource management? International Journal of Speech Technology, 24(4), 969‑977. https://doi.org/10.1007/s10772-021-09834-y

- Marr, B. (2023). The Top 10 Limitations of ChatGPT. Forbes. https://www.forbes.com/sites/bernardmarr/2023/03/03/the-top-10-limitations-of-chatgpt/

- Maurer, R. (30 avril 2019). HR and Chatbots Are Learning Together. SHRM. https://www.shrm.org/resourcesandtools/hr-topics/technology/pages/hr-chatbots-are-learning-together.aspx

- Metz, C. (15 mars 2021). Who Is Making Sure the A.I. Machines Aren’t Racist? The New York Times. https://www.nytimes.com/2021/03/15/technology/artificial-intelligence-google-bias.html

- Mydyti, H., & Kadriu, A. (2021). The Impact of Chatbots in Driving Digital Transformation. International Journal of E-Services and Mobile Applications (IJESMA), 13(4), 88‑104. https://doi.org/10.4018/IJESMA.2021100106

- OpenAI. (2022). Introducing ChatGPT. https://openai.com/blog/chatgpt

- OpenAI. (2023). GPT-4. https://openai.com/product/gpt-4

- Ray, P. P. (2023). ChatGPT: A comprehensive review on background, applications, key challenges, bias, ethics, limitations and future scope. Internet of Things and Cyber-Physical Systems, 3, 121‑154. https://doi.org/10.1016/j.iotcps.2023.04.003

- RLRQ, chapitre A-2.1. (2023). Loi sur l’accès aux documents des organismes publics et sur la protection des renseignements personnels (RLRQ, chapitre A-2.1). https://www.legisquebec.gouv.qc.ca/fr/document/lc/A-2.1

- RLRQ, chapitre P-39.1. (2023). Loi sur la protection des renseignements personnels dans le secteur privé (RLRQ, chapitre P-39.1). https://www.legisquebec.gouv.qc.ca/fr/document/lc/p-39.1

- Robert-Huot, G., & Cloutier, J. (2020). La gestion des ressources humaines dans les PME : Une analyse systématique de la littérature. Revue internationale P.M.E., 33(1), 101‑146. https://doi.org/10.7202/1069285ar

- Sheth, B. (2018). Chat bots are the new HR managers. 17(3), 162‑163. https://doi.org/10.1108/SHR-03-2018-0024

- Singh, D. (2023). ChatGPT : A New Approach to Revolutionise Organisations. International Journal of New Media Studies (IJNMS), 10(1), Article 1.

- Smith, P. (30 mars 2023). Evolution Of ChatGPT : From Chats To Powerful Collaboration. https://imeetify.com/blog/evolution-of-chatgpt-from-chats-to-powerful-collaboration/

- TalentLyft. (2020). How Can Chatbots Improve Employee Experience? Blog. https://www.talentlyft.com/en/blog/article/405/how-can-chatbots-improve-employee-experience

- Taule, T., Følstad, A., & Fostervold, K. I. (2022). How Can a Chatbot Support Human Resource Management? Exploring the Operational Interplay. Dans A. Følstad, T. Araujo, S. Papadopoulos, E. L.-C. Law, E. Luger, M. Goodwin, & P. B. Brandtzaeg (Éds.), Chatbot Research and Design (p. 73‑89). Springer International Publishing. https://doi.org/10.1007/978-3-030-94890-0_5

- The AI Article Project. (27 mars 2023). The Ethics of ChatBots : Addressing Bias and Discrimination in ChatGPT’s Responses. Medium. https://the-ai-article-project.medium.com/the-ethics-of-chatbots-addressing-bias-and-discrimination-in-chatgpts-responses-4974305b6426

- Welborn, A. (9 mars 2023). ChatGPT and Fake Citations. Duke University Libraries Blogs. https://blogs.library.duke.edu/blog/2023/03/09/chatgpt-and-fake-citations/

- Wilson, L., & Marasoiu, M. (2022). The Development and Use of Chatbots in Public Health: Scoping Review. JMIR Human Factors, 9(4), e35882. https://doi.org/10.2196/35882

ANNEXE 1

Tableau 1. Limites potentielles de ChatGPT et leurs descriptions

(contenu traduit et adapté de Ray, 2023, p. 148)

Limite

Description

Limite Informations inexactes ou trompeuses

Description Il peut générer du contenu erroné ou biaisé, car il se base sur des données d’entraînement plutôt que sur une compréhension approfondie du sujet.

Limite Sensibilité à la formulation de l’entrée

Description La sortie du modèle peut varier selon la formulation de l’entrée, conduisant à des réponses incohérentes ou à des niveaux de détail variables.

Limite Verbosité et surutilisation de certaines expressions

Description Il peut parfois produire des réponses verbeuses ou répétitives, rendant le contenu généré moins naturel.

Limite Incapacité à vérifier les faits ou à accéder à des informations en temps réel

Description Les connaissances de ChatGPT sont limitées aux données sur lesquelles il a été entraîné, avec une date limite en 2021. Il ne peut pas fournir d’informations en temps réel ou vérifier l’exactitude de ses réponses.

Limite Difficulté à gérer les requêtes ambiguës

Description Il peut avoir du mal avec les requêtes ambiguës ou les questions qui nécessitent une compréhension nuancée du contexte. Il peut générer du contenu qui ne répond pas directement à l’intention de l’utilisateur.

Limite Manque de conscience contextuelle

Description Il peut parfois générer du contenu qui manque de conscience contextuelle ou qui ne tient pas compte des ramifications plus étendues d’un sujet donné. Cela peut entraîner un contenu qui semble superficiel ou qui ne tient pas compte de la complexité des situations réelles.

Limite Raisonnement éthique et moral

Description En tant que modèle de langage, il peut avoir du mal à s’engager dans un raisonnement éthique ou moral. Il peut générer du contenu qui est moralement ambigu ou qui ne respecte pas les normes éthiques, le rendant inadapté à certaines applications sans une supervision humaine appropriée.

Limite Contextes conversationnels longs

Description ChatGPT peut avoir du mal à maintenir la cohérence et la consistance dans les contextes conversationnels longs ou lorsqu’il répond à une série de questions interconnectées. Cela peut entraîner des réponses disjointes ou contradictoires qui peuvent confondre les utilisateurs.

Limite Incapacité à créer du contenu visuel

Description En tant que modèle de langage basé sur le texte, il ne peut pas créer du contenu visuel, tel que des images, des vidéos ou des graphiques, limitant son applicabilité dans la création de contenu multimédia et les tâches de communication visuelle.

Limite Réponse aux demandes inappropriées ou nuisibles

Description Il peut avoir du mal à reconnaître et à gérer systématiquement les entrées inappropriées, nuisibles ou offensantes, générant potentiellement du contenu qui viole les lignes directrices éthiques ou les attentes des utilisateurs.

Limite Difficulté à reconnaître et à s’adapter au degré d’expertise de l’utilisateur

Description Il peut ne pas adapter efficacement son contenu généré au degré d’expertise ou à la familiarité de l’utilisateur avec un sujet précis, entraînant potentiellement des réponses trop simplistes ou trop techniques qui peuvent ne pas convenir aux besoins de l’utilisateur.

Limite Intelligence émotionnelle limitée

Description En tant que modèle de langage artificiel, ChatGPT a une intelligence émotionnelle limitée, ce qui peut entraîner la génération d’un contenu qui manque d’empathie ou qui ne reconnaît pas et ne répond pas de manière appropriée au contexte émotionnel d’une requête d’utilisateur.

Limite Manque de rétroaction personnalisée

Description En tant que modèle de langage généraliste, il peut ne pas fournir une rétroaction personnalisée adaptée aux besoins ou aux objectifs d’apprentissage des utilisateurs individuels. Cela peut limiter son efficacité dans les contextes éducatifs ou d’encadrement où un accompagnement individualisé est essentiel.

Limite Expertise limitée dans des domaines particuliers

Description Bien que ChatGPT puisse générer du contenu sur un large éventail de sujets, il peut manquer de profondeur de connaissance ou d’expertise trouvées dans des modèles d’intelligence artificielle particuliers à un domaine. Cela peut limiter son utilité dans des domaines spécialisés ou des applications où l’exactitude et la précision sont primordiales.

Limite Incapacité à interagir avec des systèmes externes

Description Étant un modèle d’intelligence artificielle basé sur le texte, il ne possède pas la capacité d’interagir directement avec des systèmes externes, tels que des bases de données, des API ou d’autres logiciels. Cela limite ses capacités dans les applications qui nécessitent un accès en temps réel aux informations ou la capacité de manipuler ou traiter des données externes.

Limite Incapacité à gérer les requêtes multilingues

Description Bien que ChatGPT ait une certaine capacité à générer du contenu dans plusieurs langues, il peut avoir du mal à gérer efficacement les requêtes qui impliquent plusieurs langues au sein d’une même entrée ou nécessitent des traductions entre les langues, ce qui pourrait limiter son utilité dans les contextes multilingues.

Limite Difficulté avec le langage non littéral

Description Il peut avoir du mal à interpréter ou à générer correctement le langage non littéral, tel que les idiomes, les métaphores ou le sarcasme. Cela peut entraîner des réponses trop littérales, manquer le sens voulu ou ne pas transmettre le ton souhaité.

Limite Créativité limitée

Description Bien qu’il puisse générer du contenu qui semble créatif, sa créativité est finalement limitée par les données d’entraînement. Cela peut entraîner un contenu qui est dérivé ou qui manque de nouveauté et d’originalité trouvées dans les œuvres créatives générées par l’homme.

Limite Surgénéralisation

Description Il peut parfois surgénéraliser lorsqu’il génère du contenu, conduisant à des réponses qui manquent de nuance ou simplifient excessivement des sujets complexes. Cela peut entraîner un contenu qui semble plausible en surface, mais qui ne traite pas avec précision les subtilités d’un sujet donné.

Limite Incohérence dans la qualité

Description La qualité de la sortie de ChatGPT peut varier en fonction de l’entrée et du sujet abordé. Cela peut entraîner des incohérences sur le plan des détails, de la cohérence ou la pertinence du contenu généré. Cela peut rendre difficile la prévision de la performance du modèle dans différents contextes ou applications.

Limite Consommation d’énergie et incidence environnementale

Description L’entraînement et l’exécution de modèles d’intelligence artificielle comme ChatGPT peuvent consommer beaucoup d’énergie, contribuant aux préoccupations environnementales et soulevant des questions sur la durabilité et les implications éthiques de leur utilisation généralisée.

Limite Difficulté à capturer l’intuition humaine

Description En tant que modèle de langage artificiel, il peut avoir du mal à capturer l’intuition humaine. Cela rend difficile pour le modèle de générer du contenu qui reflète les connaissances implicites sur lesquelles les humains s’appuient souvent lorsqu’ils communiquent ou prennent des décisions.

Limite Manque de conscience de soi

Description Il manque de conscience de soi. Il ne possède pas une compréhension de ses propres limites, biais ou lacunes. Cela rend difficile pour le modèle de générer du contenu qui reconnaît l’incertitude ou indique quand il fournit des informations incomplètes ou incorrectes.

Limite Exigences en matière de ressources pour l’entraînement et le déploiement

Description L’entraînement et le déploiement de modèles d’intelligence artificielle comme ChatGPT peuvent nécessiter beaucoup de ressources informatiques. Cela peut être un obstacle pour les petites organisations ou les particuliers qui souhaitent développer ou personnaliser des modèles pour leurs besoins particuliers.

ANNEXE 2

Tableau 2. Biais potentiels du ChatGPT et leurs descriptions

(contenu traduit et adapté de Ray, 2023, p. 147)

Limite

Description

Limite Préjugés culturels et linguistiques

Description Il peut favoriser certaines cultures ou langues plus représentées en ligne, car il est entraîné sur des données provenant principalement d’internet. Cela peut entraîner la génération de contenu qui ne reflète pas fidèlement la diversité des expériences ou des langues humaines.

Limite Préjugés sexistes et raciaux

Description Il peut involontairement perpétuer des stéréotypes de genre et de race en raison des biais dans les données d’entraînement. Par exemple, le modèle peut associer certaines professions ou certains rôles à des genres ou des ethnies particuliers, renforçant ainsi les stéréotypes existants.

Limite Biais dans les recommandations de contenu

Description Il peut biaiser les recommandations de contenu en fonction des croyances ou des préférences existantes de l’utilisateur, contribuant potentiellement à la création de bulles de filtres et de polarisation.

Limite Biais idéologique

Description Il peut refléter les opinions ou les points de vue dominants trouvés dans ses données d’entraînement. Cela peut conduire à la génération de contenu qui penche vers des idéologies politiques, sociales ou économiques précises, renforçant potentiellement les biais existants ou créant une représentation déséquilibrée des différentes perspectives.

Limite Biais de sensationnalisme et de clickbait

Description ChatGPT peut apprendre des schémas liés au contenu sensationnaliste ou clickbait, car il s’entraîne sur des données provenant d’internet. Cela pourrait entraîner la génération de titres accrocheurs, d’exagérations ou d’autres formes de sensationnalisme dans le contenu qu’il produit.

Limite Biais de confirmation

Description Ses réponses peuvent confirmer des croyances, des hypothèses ou des stéréotypes existants dans les données d’entraînement. Cela peut limiter la diversité des perspectives et renforcer les points de vue biaisés.

Limite Biais temporel

Description Il peut être biaisé par les données provenant de périodes données. Cela peut conduire à la génération de contenu qui reflète les tendances, les croyances ou les points de vue prévalents à ces époques, qui peuvent ne pas être pertinents ou appropriés pour le contexte actuel.

Limite Biais d’exclusion

Description ChatGPT peut exclure ou marginaliser certaines perspectives ou certains groupes sous-représentés dans ses données d’entraînement. Cela peut conduire à un contenu qui manque d’inclusivité et qui ne reflète pas les expériences de tous les utilisateurs.

Limite Biais commercial

Description Les données d’entraînement de ChatGPT, qui proviennent principalement d’internet, peuvent contenir un biais commercial, car elles reflètent les objectifs et les intérêts des entités commerciales. Cela peut conduire à la génération de contenu qui promeut involontairement des produits, des services ou des marques, même lorsque ce n’est pas l’intention de l’utilisateur.

Limite Biais cognitif

Description Il peut adopter des biais cognitifs présents dans les données, car il apprend du contenu humain. Ces biais peuvent biaiser le contenu vers un raisonnement erroné ou des généralisations.

Limite Biais d’attention

Description ChatGPT peut développer un biais d’attention en apprenant du contenu qui a reçu plus d’attention en ligne. Cela peut biaiser le contenu vers les points de vue populaires ou largement discutés, éclipsant les perspectives moins courantes ou les voix sous-représentées.

Limite Biais de format

Description Les données d’entraînement de ChatGPT peuvent contenir un biais de format, car elles sont principalement composées de contenu textuel provenant d’internet. Cela peut entraîner le modèle étant moins habile à générer du contenu qui reflète d’autres formes de communication, telles que le langage parlé ou les signaux non verbaux.

Limite Biais de source

Description Il peut être biaisé par les données qui proviennent de sources en ligne qui peuvent ne pas être fiables, crédibles ou faisant autorité. Cela peut biaiser le contenu vers des informations basées sur des sources moins dignes de confiance ou accordant trop d’importance à certaines sources.

Limite Biais de nouveauté

Description Il peut générer du contenu qui est plus similaire aux sujets populaires ou tendance, en négligeant ou en minimisant les perspectives moins connues ou émergentes, car il apprend à partir des schémas et associations trouvés dans ses données d’entraînement.

Limite Biais de sentiment positif/négatif

Description Son contenu peut être orienté vers un sentiment positif ou négatif, en fonction de la prévalence d’un tel sentiment dans ses données d’entraînement. Cela peut biaiser le contenu vers une vision trop optimiste ou pessimiste de certains sujets ou certaines situations.

Limite Biais d’extrême valeur

Description Des exemples extrêmes ou inhabituels qui ne sont pas représentatifs des situations ou perspectives typiques peuvent être utilisés. Cela peut biaiser le contenu vers des vues extrêmes ou exagérées, déformant la compréhension d’un sujet.

Limite Biais implicite

Description Ses réponses peuvent contenir des biais qui ne sont pas explicitement présents dans les données, mais qui émergent des relations entre les concepts et les idées. Ces biais peuvent influencer subtilement le contenu, les rendant difficiles à détecter et à traiter.

Limite Biais d’autorité

Description Il peut accorder plus de poids au contenu ou aux points de vue provenant de sources perçues comme faisant autorité ou influentes dans ses données d’entraînement. Cela peut conduire à la priorisation du modèle des informations provenant d’individus ou d’organisations bien connus, négligeant potentiellement des informations précieuses provenant de sources moins prestigieuses.

Limite Biais de récence

Description Il peut accorder plus d’importance aux événements récents ou actuels, aux tendances ou aux croyances dans son contenu généré. Cela peut conduire le modèle à négliger le contexte historique ou à sous-estimer la pertinence des expériences et connaissances passées.

Limite Biais de conformisme

Description Il peut involontairement générer du contenu qui reflète les points de vue ou opinions consensuels trouvés dans ses données d’entraînement. Cela peut limiter la diversité des perspectives et entraver l’exploration des points de vue alternatifs ou dissidents.

Limite Biais d’ancrage

Description Ce biais se produit lorsque le modèle accorde trop d’importance à des éléments précis d’information ou à des impressions initiales provenant de ses données d’entraînement. Cela peut entraîner la génération de contenu qui est indûment influencé par certains détails ou exemples, conduisant potentiellement à des perspectives déformées ou déséquilibrées.

Limite Biais de disponibilité

Description Ses réponses peuvent être affectées par le biais de disponibilité, qui se réfère à la tendance à prioriser les informations qui sont plus facilement rappelées ou aisément disponibles dans ses données d’entraînement. Cela peut amener le modèle à générer du contenu qui surestime les exemples communs ou bien connus tout en négligeant les informations moins évidentes, mais également pertinentes.

Limite Biais de faux consensus

Description Il peut développer un biais de faux consensus en surestimant la mesure dans laquelle ses données d’entraînement représentent un consensus plus large ou une compréhension partagée. Cela peut conduire à la génération de contenu qui suppose un degré plus élevé d’accord sur certains sujets ou points de vue qu’il n’existe réellement.

Limite Biais de rétrospective

Description Il peut présenter un biais de rétrospective, qui se produit lorsque le modèle surestime la prévisibilité ou l’inévitabilité des événements passés en fonction des informations disponibles dans ses données d’entraînement. Cela peut entraîner la génération de contenu qui présente une vision biaisée des événements ou des résultats historiques.